1 Introduction

- 두 개의 visual domains 사이의 mapping을 학습하기 위해 두 가지 어려움 점 존재.

- aligned training image pairs 수집이 어려움.

- many such mappings are inherently multimodal

- single input에 대해 다수의 output 존재 가능성.

- multi modal 은 아래 그림과 같이 age로 변환된다고 하더라도 20대 input이 40대나 50대, 60대의 다양한 output으로 변환하는 것을 의미.

- 이를 해결하기 위해 stargan과 같은 방법론 제안되었지만, 주어진 input image에 대해 single output만 생성되는 한계

- generator에 noise vectors를 input으로 추가하는 방법들은 mode collapse issue로 인해 생성된 이미지들의 variations을 증가시키지는 못 함.

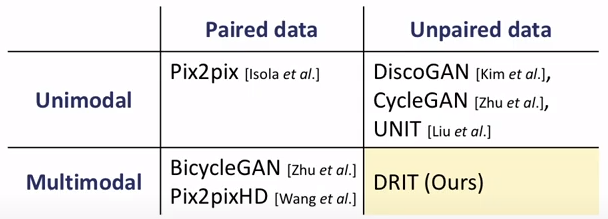

- 이 논문에서는 unpaired training data 조건에서 diverse outputs을 생성하기 위한 방법 제안.

- 이미지를 두 개의 spaces로 임베디드 시키는 방법 제안.

- domain-invariant content space

- a domain-specific attribute space

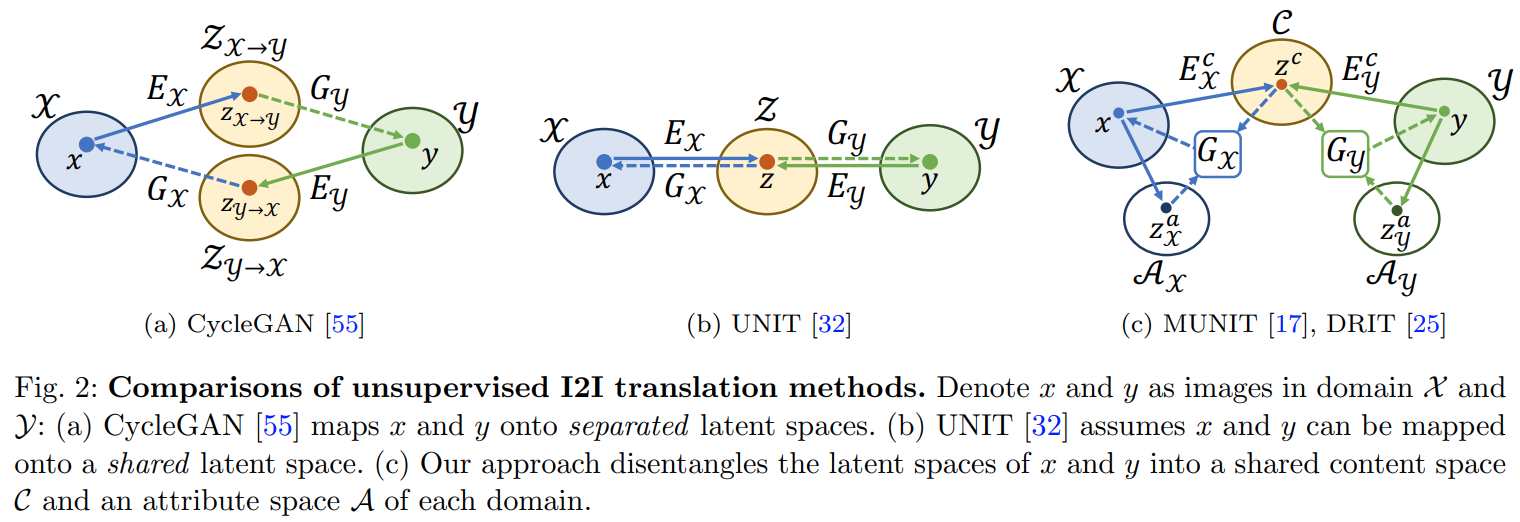

- 아래 그림중 (c)는 MUNIT와 DRIT 에 대한 설명인데 input image를 content와 attribute(style)로 구분해서 embedding 한다는 점에서 유사.

위 그림을 보면 MUNIT와 DRIT 은 매우 유사

아래는 MUNIT에 대한 설명.

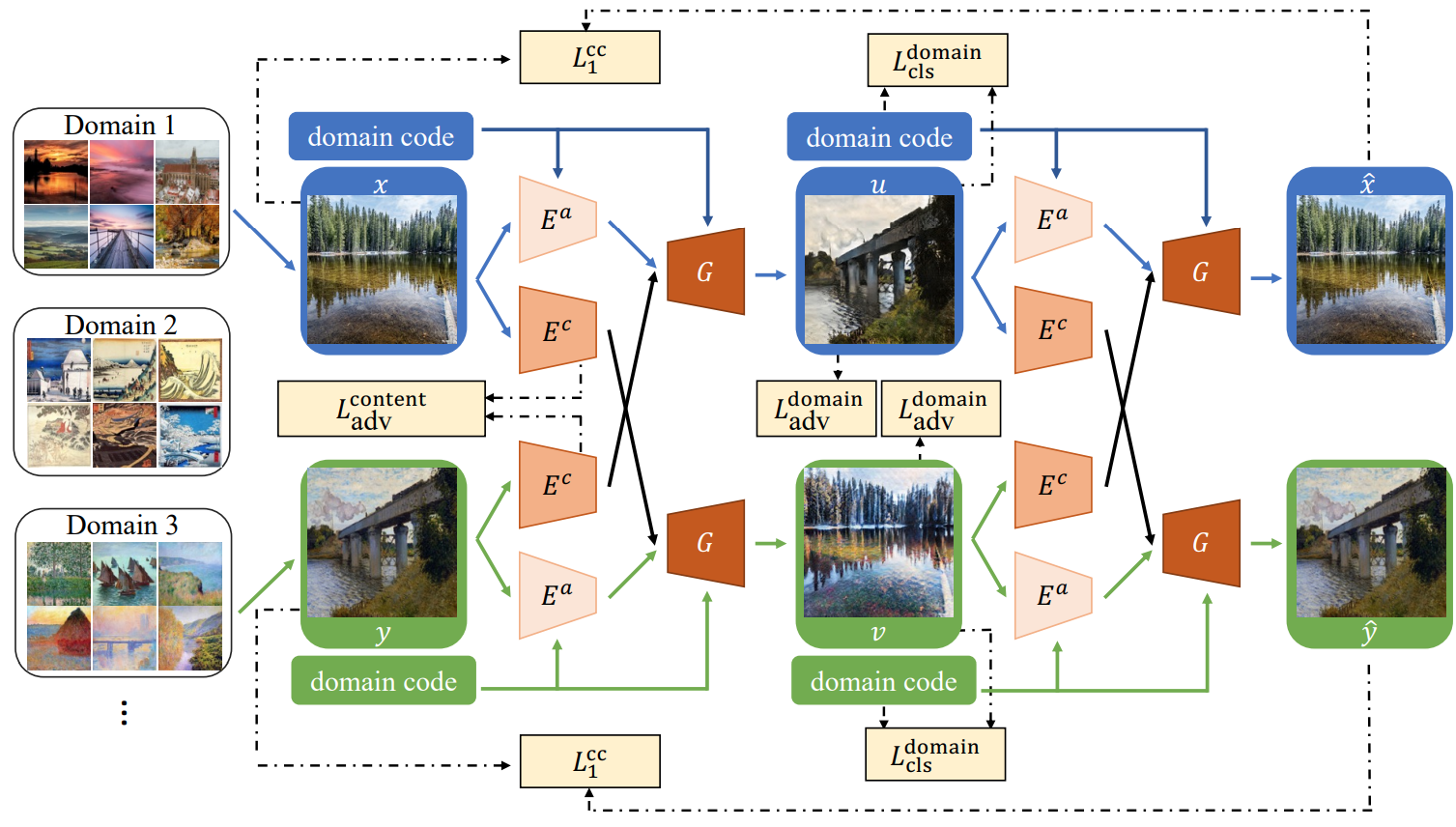

DRIT에서는 어떤 점이 달라지는지 보자. content encoder에서 weight sharing 하는 부분과 style code에서 concat하는 부분이 다름.

또한, content discriminators를 추가 함.

2 Related Work

Image-to-image translation

- noise vector 를 generator에 단순하게 추가하는 것으로는 noise vectors와 target domain 사이의 regularization이 부족하기 때문에 효과적으로 multimodal generation을 생성하는 방법이 될 수 없다.

3 Disentangled Representation for I2I Translation

- 두 개의 domain 사이에서 multimodal mapping 학습이 목표.

- content encoders {Ec X , Ec Y }와 attribute encoders {Ea X , Ea Y }, generators {GX , GY }, domain discriminators {DX , DY }, content discriminators Dc adv 총 encoders 4개 generators 2개, discriminators 3개로구성

3.1 Disentangle Content and Attribute Representations

- input images를 a shared content space C, and domain-specific attribute spaces, AX and AY 로 임베딩.

- content encoders는 space C 상에서 도메인 간 공유 가능한 정보를 잘 임베딩 해야 함. 예를 들어 개/고양이 domain 사이에 자세, 표정 등은 공유 가능 함. 하지만 코나, 눈의 생김새, 고양이 수염 등은 omain-specific attribute spaces로 임베딩 되어야 함.

- representation disentanglement를 얻기 위해 weight-sharing and a content discriminator를 수행.

- 먼저, Ec X and Ec Y의 last layer, first layer of GX and GY 를 weight-sharing한다.이를 통해 content representation이 동일 space 상으로 매핑되도록 한다.

- 하지만, 동일한 highlevel mapping functions 이 동일한 content representations가 두 도메인에 대해 동일한 information을 인코딩하는 것은 아님.

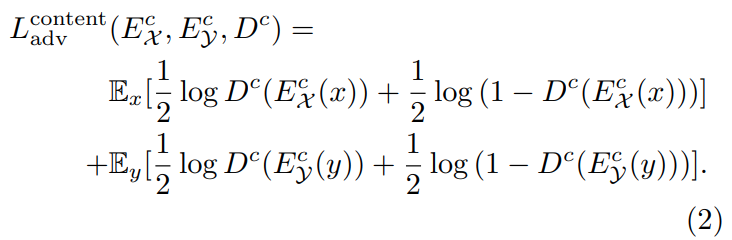

- encoded content features z c x and z c y를 구분할 수 있는 content discriminator Dc 제안.

- content encoders는 content discriminator Dc에 의해 구분이 어렵도록 encoded content representations을 생성하도록 학습된다.

3.2 Cross-cycle Consistency Loss

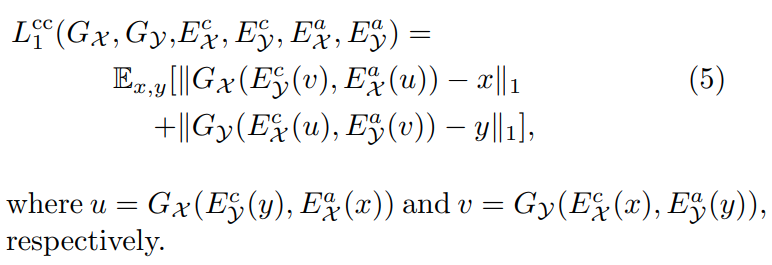

아래 그림과 같은 Forward/Backward translation 과정을 거치면 cross-cycle consistency loss

3.3 Other Loss Functions

content adversarial loss and cross-cycle consistency loss 외에 Domain adversarial loss, Self-reconstruction loss, Latent regression loss 추가.

- Domain adversarial loss

- DX and DY 가 각 domain의 real images and generated images를 구분하도록 학습하고 GX and GY는 realistic images를 생성하려고 하는 일반적인 adversarial loss

- Self-reconstruction loss.

- Latent regression loss.

- To encourage invertible mapping between the image and the latent space, we apply a latent regression loss L latent

3.5 Multi-Domain Image-to-Image Translation